NVIDIAについて

NVIDIA は1999 年にGPU を発明して以来、ビジュアル コンピューティング分野を牽引しています。

2006 年に誕生したCUDA プログラミング モデルおよび Tesla GPU プラットフォームにより、GPU がビジュアル コンピューティング分野だけでなく並列計算能力を利用した汎用コンピューティングに適用することが可能になりました。

CUDAのツールとライブラリは3000万回以上ダウンロードされ、約300万人の開発者によって使用されています。CUDAプラットフォームは、より強力なCUDA対応GPU、新しく多様なGPUアクセラレーションライブラリ、ワークステーション、サーバー、およびアプリケーションのセットにより、継続的に改善、最適化、および拡張されています。

NVIDIA CUDA 汎用プログラマブル GPU と多数の GPU アクセラレーション SDK、API、およびアルゴリズムの組み合わせにより複数のドメインにわたって驚異的なアプリケーションの高速化を実現します。 NVIDIA GPUは世界中のクラウド データ センターで使用されており、AI、HPC、およびデータ分析システムとアプリケーションの驚異的なスピードを提供します。プログラミングの容易さと NVIDIA の CUDA プラットフォームの豊富さにより、デザイナー、研究者、エンジニアなどはイノベーションを素早く起こすことが可能です。

今日、GPU汎用コンピューティングは HPC およびデータ センターに利用されている最も一般的で、最も入手しやすく、最もエネルギー効率の高いテクノロジです。

NVIDIAはGPU汎用コンピューティング分野において世界を牽引するTOP企業です。

製品ラインアップ

NVIDIA データセンター向けGPU

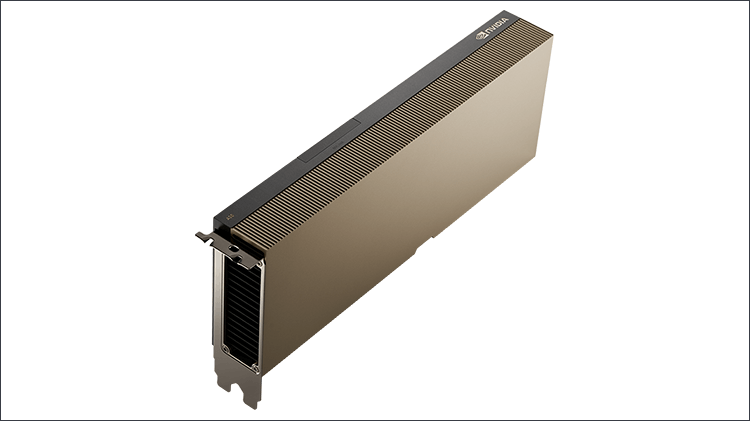

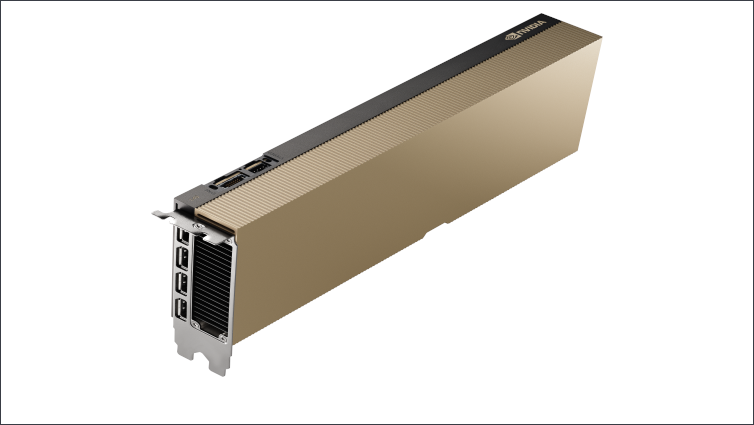

【NEW】NVIDIA H100

コンピューティング/ハイエンド

前例のないパフォーマンス

スケーラビリティ、および

すべてのデータセンターのセキュリティ

Partner and NVIDIA Certified

Systems with 1–8 GPUs

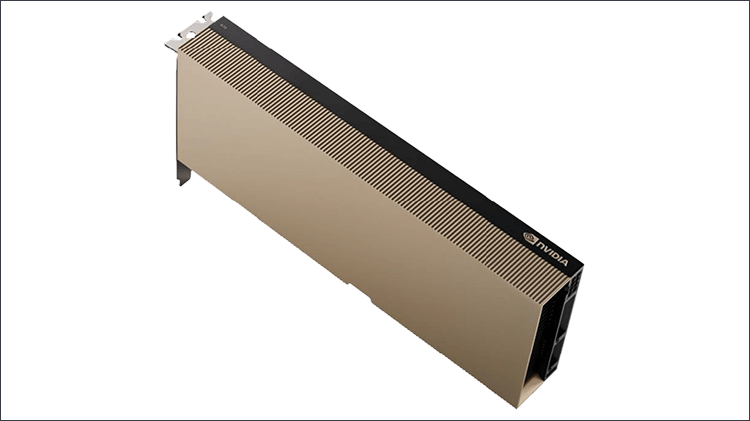

【NEW】NVIDIA L40

グラフィックス/ハイエンド

NVIDIA オムニバースエンタープライズ

レンダリング、3Dグラフィックス

NVIDIA RTX Virtual Workstation

(RTX vWS)ソフトウエア

ハイパフォーマンス ビジュアルグラフィックスAI トレーニング、データサイエンス

Ada Lovelace | 48GB GDDR6

300W | 4.4” (H) x 10.5” (L)dual slot

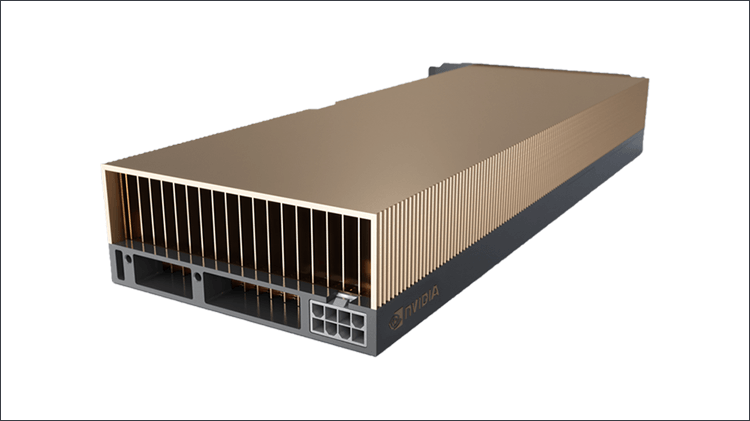

NVIDIA A100

コンピューティング/ハイエンド

コンピューティングのハイエンド

AI学習、HPC、データ処理

最速コンピューティング、FP64

最大7つのMIGインスタンス

250W & 300W | 40GB & 80GB

2-slot FHFL | NVLINK

NVIDIA A30

コンピューティング/スタンダード

コンピューティングのスタンダード

AI推論、データ処理

用途の広いメインストリーム

コンピューティングFP64

最大4つのMIGインスタンス

165W | 24GB

2-slot FHFL | NVLINK

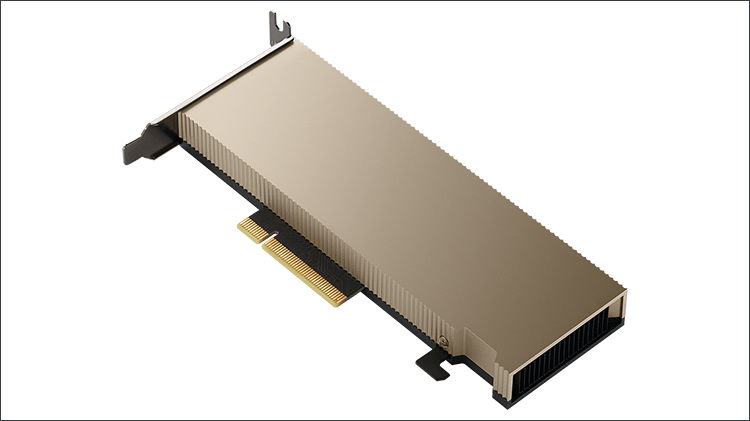

NVIDIA A2

コンピューティンググラフィックス

スモールエッジ AI

インテリジェントビデオ分析

モバイル クラウドゲーミング

コンパクトで低消費電力

データセンターとエッジ推論

40-60W | 16GB

1-slot LOW Profile

NVIDIA A40

グラフィックス/ハイエンド

グラフィックスのハイエンド

レンダリング、デザイン、

Omniverse、CloudXR

最速のRTグラフィックス

最高のレンダリングモデル

300W | 48GB

2-slot FHFL | NVLINK

NVIDIA A16

グラフィックス/スタンダード

グラフィックスのスタンダード

オフィス仮想デスクトップ用

高密度搭載可能モデル

高解像度、マルチモニター、

大容量のエンコード/デコードストリーム

250W | 64G (4 x 16GB)

2-slot FHFL

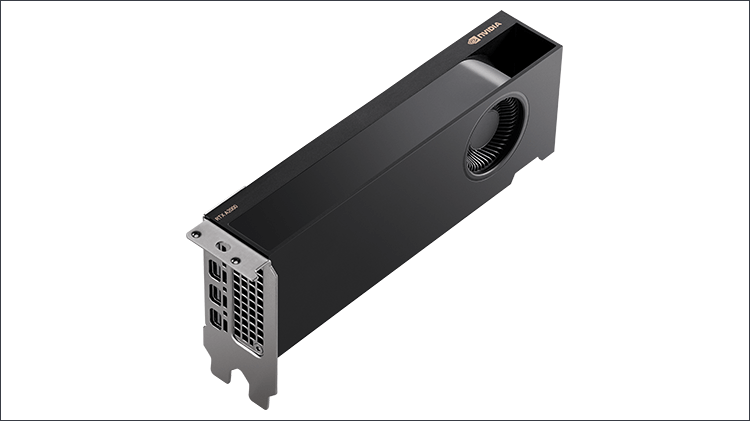

NVIDIA RTX Desktop Workstation向けGPU

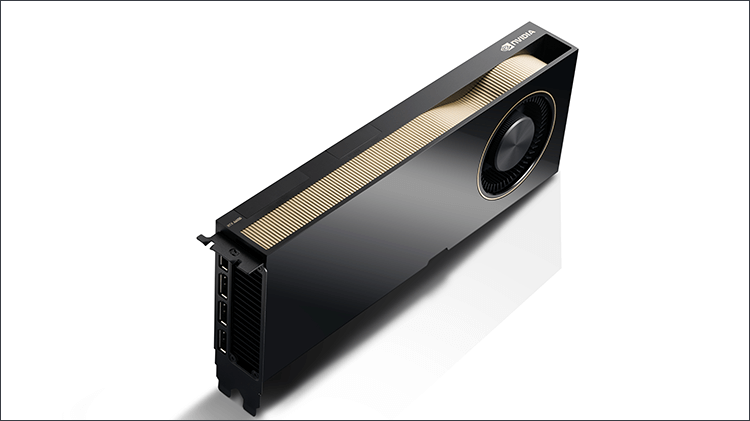

【NEW】NVIDIA RTX 6000 Ada

ウルトラハイエンド

無限の可能性を実現するパフォーマンス

ハイエンド デザインリアルタイム レンダリング、AI、および高性能コンピューティング ワークフロー

Ada Lovelace | 48GB GDDR6

300W |4.4” (H) x 10.5” (L)

Dual Slot

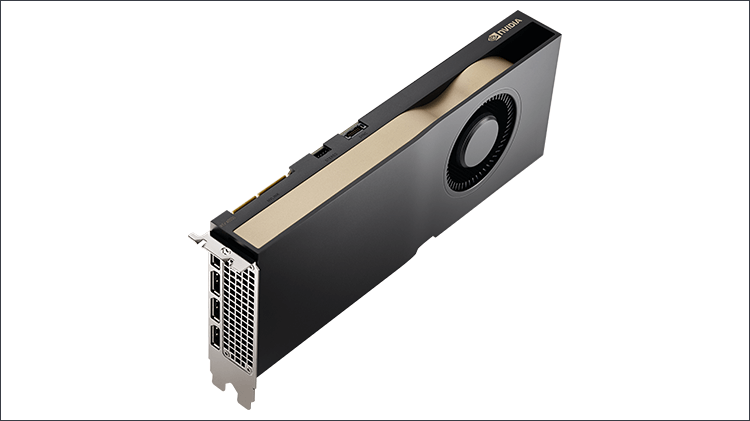

NVIDIA RTX A6000

ウルトラハイエンド

超大規模CAD/3Dモデル、CAE

複雑なインタラクティブ レイトレーシング

超高解像度レンダリング

DeepLearning・Machine Learning

Ampere | 48 GB GDDR6

300W |4.4” (H) x 10.5” (L)

Dual Slot

NVIDIA RTX A5500

ハイエンド

大規模で複雑なCAD/3Dモデル

AIのエントリー

インタラクティブ レイトレーシング

超高解像度レンダリング

Ampere | 24 GB GDDR6

230W | 4.4” (H) x 10.5” (L)

Dual Slot

NVIDIA RTX A4500

ハイエンド

大規模で複雑なCAD/3Dモデル

AIのエントリー

インタラクティブ レイトレーシング

超高解像度レンダリング

Ampere | 24 GB GDDR6

200W | 4.4” (H) x 10.5” (L)

Dual Slot

NVIDIA RTX A2000-12G

ミッド、スモール

ミッド、スモールCAD/3Dモデル

簡易AI、レイトレーシング

Ampere | 12 GB GDDR6

70 W | 2.7“(H)x6.6”(L)

Dual Slot

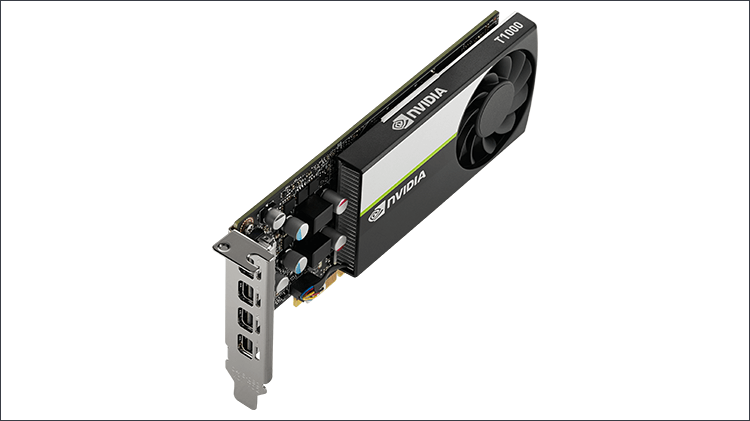

NVIDIA T1000-8G

ローエンド

部品のデザイン

マルチアプリワークフロー

Turing | 8GB GDDR6

50W | 2.7”(H) x6.2”(L)

Single Slot

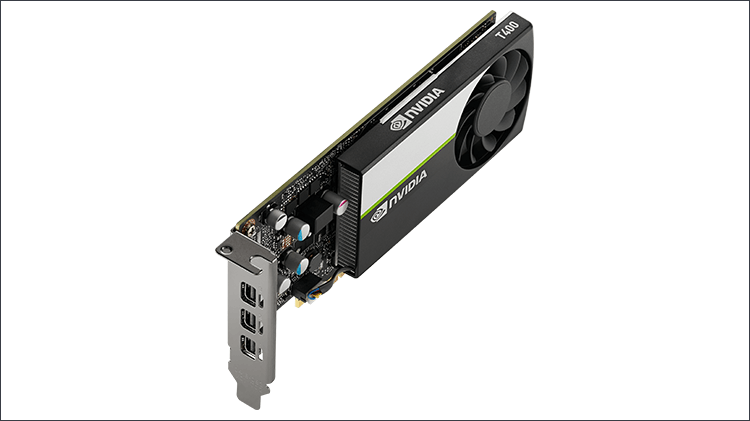

NVIDIA T400-4G

ローエンド

部品のデザイン

マルチアプリワークフロー

Turing | 4GB GDDR6

30W | 2.7”(H) x6.2”(L)

Single Slot